Na tym blogu omówimy poniższe treści:

- Jak dostosować generowanie tekstu, ładując model z funkcją „potoku” z Transformers?

- Jak wykorzystać model oparty na transformatorze do generowania tekstu w PyTorch?

- Jak wykorzystać model oparty na transformatorze do generowania tekstu w TensorFlow?

Jak dostosować generowanie tekstu, ładując model z funkcją „potoku” z Transformers?

„ rurociąg ” służy do automatycznego pobierania wstępnie wytrenowanego modelu AI zgodnie z wymaganiami użytkownika. Aby korzystać z tej konkretnej funkcji, użytkownicy muszą zainstalować „ transformatory ”pakiety. Ten pakiet zapewnia dostęp do najnowocześniejszych modeli opartych na transformatorach, które umożliwiają przeprowadzanie analizy nastrojów oraz wielu innych Przetwarzanie języka naturalnego (NLP) zadania.

Aby zapoznać się z praktyczną demonstracją opisanego powyżej scenariusza, przejdź do poniższych kroków!

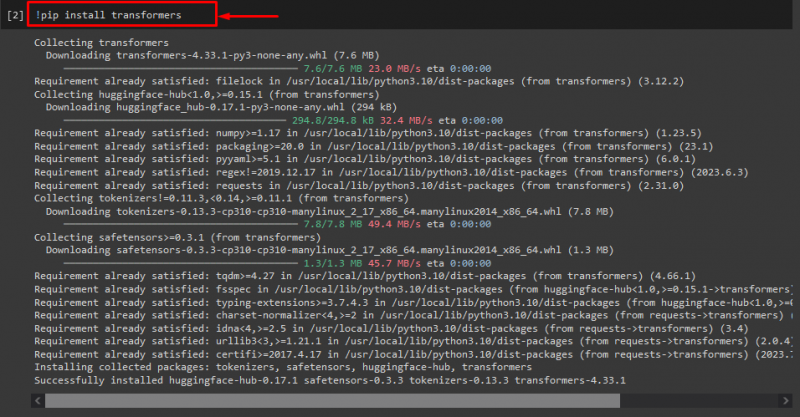

Krok 1: Zainstaluj pakiety „transformatory”.

Początkowo wykonaj polecenie „! pypeć' polecenie instalacji pakietów transformatora:

! pip zainstaluj transformatory

Jak widać, określony pakiet został pomyślnie zainstalowany:

Krok 2: Importuj model oparty na transformatorze

Następnie zaimportuj wymagany model oparty na transformatorze. Aby to zrobić, najpierw zaimportuj plik „ rurociąg ” funkcja z „ transformatory ”. Następnie użyj zaimportowanej funkcji i przekaż „ generowanie tekstu ” jako argument wraz z wymaganą nazwą modelu „ gpt2 ”. Następnie przekaż je „ Generować ' zmienny:

z transformatory import rurociąg

Generować = rurociąg ( „generowanie tekstu” , Model = „gpt2” )

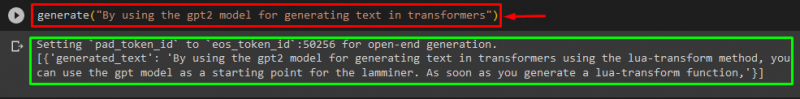

Krok 3: Wygeneruj Dostosuj tekst

Teraz przekaż żądany tekst jako argument do funkcji „ Generować ”. Jak pokazano niżej:

Generować ( „Wykorzystując model gpt2 do generowania tekstu w transformatorach” )Zgodnie z dostarczonymi danymi wyjściowymi, pobrany wstępnie wytrenowany „ gpt3 ” model został pomyślnie wygenerowany tekst:

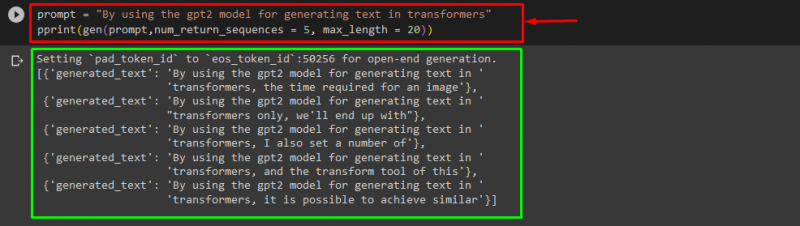

Możesz także użyć innych argumentów, takich jak:

podpowiedź = „Wykorzystując model gpt2 do generowania tekstu w transformatorach”wydrukować ( gen ( podpowiedź , num_return_sequences = 5 , maksymalna długość = 20 ) )

Tutaj:

- „ podpowiedź ” jest używane jako argument podtrzymujący dane wejściowe.

- „ num_return_sekwencja Argument ” służy do wygenerowania liczby sekwencji podanego tekstu.

- „ maksymalna długość Argument ” służy do określenia długości generowanego tekstu. W naszym przypadku ogranicza się to do „ 30 tokeny (słowa lub znaki interpunkcyjne):

Notatka: Dostosowany tekst będzie kontynuacją określonego monitu opartego na danych szkoleniowych modelu.

Jak wykorzystać model oparty na transformatorze do generowania tekstu w PyTorch?

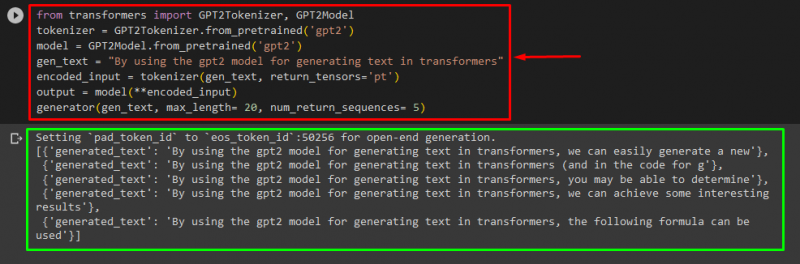

Użytkownicy mogą również dostosować tekst w „ PyTorch ' który jest ' Latarka framework oparty na uczeniu maszynowym. Jest wykorzystywany do różnych zastosowań, takich jak NLP i wizja komputerowa. Aby użyć modelu opartego na transformatorze do dostosowywania tekstu w PyTorch, najpierw zaimportuj „ Tokenizer GPT2 ' I ' Model GPT2 ” funkcje z „ transformatory ”:

z transformatory import Tokenizer GPT2 , Model GPT2Następnie skorzystaj z opcji „ Tokenizer GPT2 ” tokenizer zgodnie z naszym pożądanym, wstępnie wytrenowanym modelem o nazwie „ gpt2 ”:

tokenizator = Tokenizer GPT2. od_wstępnie przeszkolonego ( „gpt2” )Następnie utworzenie instancji wag ze wstępnie wytrenowanego modelu:

Model = Model GPT2. od_wstępnie przeszkolonego ( „gpt2” )Następnie zadeklaruj „ gen_tekst ” zmienna przechowująca tekst, który chcemy dostosować:

gen_tekst = „Wykorzystując model gpt2 do generowania tekstu w transformatorach”Teraz przekaż „ gen_tekst ' I ' return_tensors=‘pt’ ” jako argument, który wygeneruje tekst w PyTorch i zapisze wygenerowaną wartość w „ zakodowane_wejście ' zmienny:

zakodowane_wejście = tokenizator ( gen_tekst , powrotne_tensory = „pt” )Na koniec przekaż „ zakodowane_wejście ”, która przechowuje dostosowany tekst w „ Model ” jako parametr i uzyskaj wynikowy wynik za pomocą „ maksymalna długość argument ustawiony na „ 20 ”, co oznacza, że wygenerowany tekst będzie ograniczony do dostarczonych tokenów, „ num_return_sequences ” ustawione na „ 5 ”, co pokazuje, że wygenerowany tekst będzie opierał się na 5 sekwencjach tekstu:

wyjście = Model ( **zakodowane_wejście )generator ( gen_tekst , maksymalna długość = 20 , num_return_sequences = 5 )

Wyjście

Jak wykorzystać model oparty na transformatorze do generowania tekstu w TensorFlow?

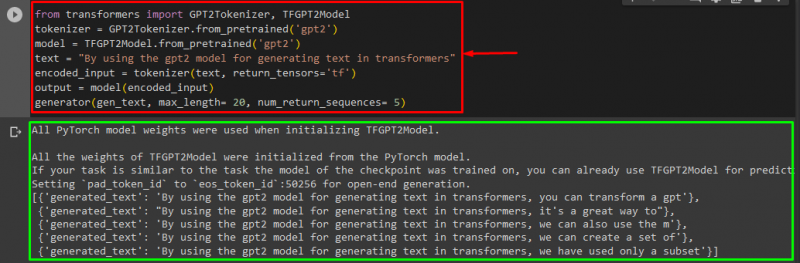

Do generowania tekstu w Transformersach służy „ TensorFlow Wykorzystywane są również frameworki uczenia maszynowego oparte na uczeniu maszynowym. Aby to zrobić, najpierw zaimportuj wymagane funkcje, takie jak „ Tokenizer GPT2 ' I ' Model TFGPT2 ” z „ transformatory ”. Reszta kodu jest taka sama jak powyżej, używamy tylko „ Model TFGPT2 ” zamiast funkcji „ Model GPT2 ”funkcja. Następująco:

z transformatory import Tokenizer GPT2 , Model TFGPT2tokenizator = Tokenizer GPT2. od_wstępnie przeszkolonego ( „gpt2” )

Model = Model TFGPT2. od_wstępnie przeszkolonego ( „gpt2” )

tekst = „Wykorzystując model gpt2 do generowania tekstu w transformatorach”

zakodowane_wejście = tokenizator ( tekst , powrotne_tensory = „tf” )

wyjście = Model ( zakodowane_wejście )

generator ( gen_tekst , maksymalna długość = 20 , num_return_sequences = 5 )

Jak widać, dostosowany tekst został pomyślnie wygenerowany:

Otóż to! Opracowaliśmy możliwości dostosowywania generowania tekstu w Transformersach.

Wniosek

Aby dostosować generowanie tekstu w Transformersach, istnieją różne sposoby, takie jak ładowanie modelu za pomocą funkcji potoku, użycie modelu opartego na transformatorze w „ PyTorch ' I ' TensorFlow ”, które opierają się na frameworkach uczenia maszynowego. W tym przewodniku zamieściliśmy krótkie informacje wraz z praktyczną demonstracją dostosowywania generowania tekstu w Transformersach.