Ten przewodnik zilustruje proces uruchamiania LLMCains w LangChain.

Jak uruchomić LLMCains w LangChain?

LangChain zapewnia funkcje lub zależności do budowania LLMChains przy użyciu LLM/Chatbotów i szablonów podpowiedzi. Aby poznać proces budowania i uruchamiania LLMCains w LangChain, postępuj zgodnie z poniższym przewodnikiem krok po kroku:

Krok 1: Zainstaluj pakiety

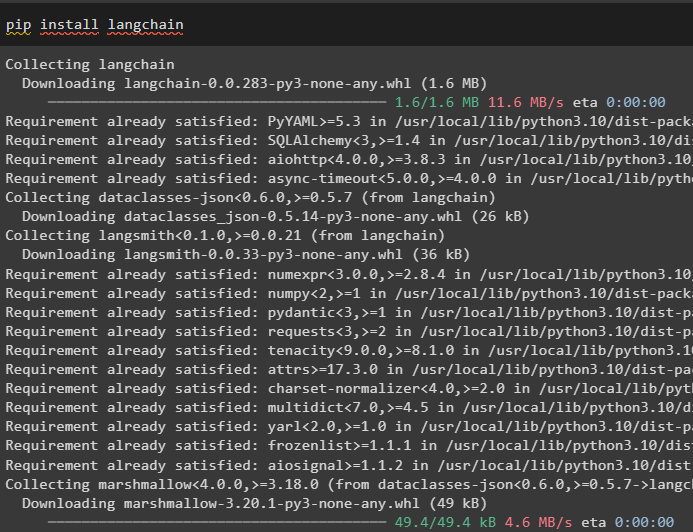

Najpierw rozpocznij proces, instalując moduł LangChain, aby uzyskać jego zależności do budowania i uruchamiania LLMChains:

pip zainstaluj langchain

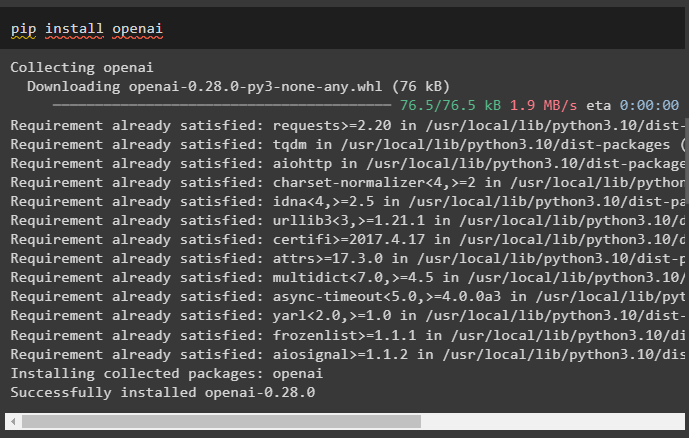

Zainstaluj środowisko OpenAI za pomocą polecenia pip, aby biblioteki mogły używać funkcji OpenAI() do tworzenia LLM:

pip zainstaluj openai

Po zainstalowaniu modułów po prostu skonfiguruj środowisko zmienne przy użyciu klucza API z konta OpenAI:

import Ty

import przejść dalej

Ty . około [ „OPENAI_API_KEY” ] = przejść dalej . przejść dalej ( „Klucz API OpenAI:” )

Krok 2: Importuj biblioteki

Po zakończeniu instalacji i zainstalowaniu wszystkich wymaganych pakietów zaimportuj wymagane biblioteki w celu zbudowania szablonu podpowiedzi. Następnie po prostu zbuduj LLM przy użyciu metody OpenAI() i skonfiguruj LLMChain przy użyciu LLM i szablonu podpowiedzi:

z łańcuch językowy import Szablon podpowiedziz łańcuch językowy import OpenAI

z łańcuch językowy import LLMCain

szablon_podpowiedzi = „podaj mi dobrą nazwę firmy, która produkuje {produkt}?”

llm = OpenAI ( temperatura = 0 )

llm_chain = LLMCain (

llm = llm ,

podpowiedź = Szablon podpowiedzi. Z szablonu ( szablon_podpowiedzi )

)

llm_chain ( 'kolorowe ubrania' )

Krok 3: Uruchamianie łańcuchów

Uzyskaj listę wejściową zawierającą różne produkty produkowane przez firmę i uruchom łańcuch, aby wyświetlić listę na ekranie:

lista_wejściowa = [{ 'produkt' : 'skarpety' } ,

{ 'produkt' : 'komputer' } ,

{ 'produkt' : 'buty' }

]

llm_chain. stosować ( lista_wejściowa )

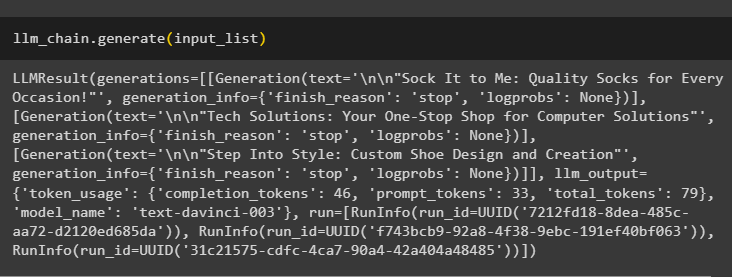

Uruchom metodę generate() za pomocą metody lista_wejściowa za pomocą LLMChains, aby uzyskać dane wyjściowe związane z rozmową wygenerowaną przez model:

llm_chain. Generować ( lista_wejściowa )

Krok 4: Korzystanie z pojedynczego wejścia

Dodaj kolejny produkt, aby uruchomić LLMChains, używając tylko jednego wejścia, a następnie przewiduj, że LLMChain wygeneruje dane wyjściowe:

llm_chain. przewidywać ( produkt = 'kolorowe skarpetki' )Krok 5: Korzystanie z wielu wejść

Teraz zbuduj szablon do korzystania z wielu danych wejściowych w celu dostarczenia polecenia modelowi przed uruchomieniem łańcucha:

szablon = '''Opowiedz mi {przymiotnik} dowcip na temat {temat}.'''podpowiedź = Szablon podpowiedzi ( szablon = szablon , zmienne_wejściowe = [ 'przymiotnik' , 'temat' ] )

llm_chain = LLMCain ( podpowiedź = podpowiedź , llm = OpenAI ( temperatura = 0 ) )

llm_chain. przewidywać ( przymiotnik = 'smutny' , temat = „kaczki” )

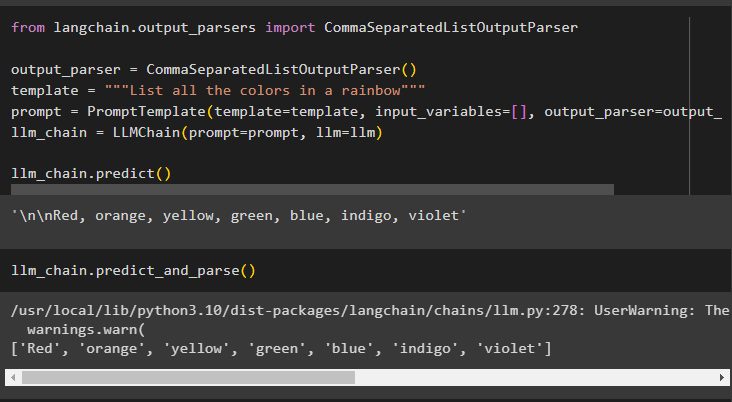

Krok 6: Korzystanie z parsera wyjściowego

W tym kroku używana jest metoda analizatora składni wyjściowej w celu uruchomienia LLMCain w celu uzyskania danych wyjściowych na podstawie podpowiedzi:

z łańcuch językowy. parsery_wyjściowe import CommaSeparatedListOutputParserparser_wyjściowy = CommaSeparatedListOutputParser ( )

szablon = '''Wymień wszystkie kolory tęczy'''

podpowiedź = Szablon podpowiedzi ( szablon = szablon , zmienne_wejściowe = [ ] , parser_wyjściowy = parser_wyjściowy )

llm_chain = LLMCain ( podpowiedź = podpowiedź , llm = llm )

llm_chain. przewidywać ( )

Użycie metody parse() do uzyskania wyniku spowoduje wygenerowanie listy oddzielonych przecinkami wszystkich kolorów tęczy:

llm_chain. przewidywać_i_parsować ( )

Krok 7: Inicjowanie z ciągów

W tym kroku wyjaśniono proces używania ciągu jako zachęty do uruchomienia LLMChain przy użyciu modelu i szablonu LLM:

szablon = '''Opowiedz mi {przymiotnik} dowcip na temat {temat}'''llm_chain = LLMCain. z_ciągu ( llm = llm , szablon = szablon )

Podaj wartości zmiennych w wierszu zachęty, aby uzyskać dane wyjściowe z modelu, uruchamiając LLMChain:

llm_chain. przewidywać ( przymiotnik = 'smutny' , temat = „kaczki” )Chodzi o uruchomienie LLMChains przy użyciu frameworka LangChain.

Wniosek

Aby zbudować i uruchomić LLMChains w LangChain, zainstaluj wymagania wstępne, takie jak pakiety i skonfiguruj środowisko przy użyciu klucza API OpenAI. Następnie zaimportuj wymagane biblioteki do skonfigurowania szablonu podpowiedzi i modelu do uruchamiania LLMChain przy użyciu zależności LangChain. Użytkownik może używać parserów wyjściowych i poleceń łańcuchowych do uruchamiania LLMCains, jak pokazano w przewodniku. W tym przewodniku szczegółowo opisano cały proces uruchamiania LLMCains w LangChain.