LangChain to framework zawierający wiele zależności i bibliotek, których można używać do budowania dużych modeli językowych. Modeli tych można używać do interakcji z ludźmi, ale najpierw model musi nauczyć się, jak uzyskać/rozumieć podpowiedź/pytanie zadawane przez człowieka. W tym celu należy wytrenować model na szablonach podpowiedzi, a następnie użytkownik zadaje pytanie w ramach danego szablonu.

Ten przewodnik ilustruje proces tworzenia szablonów podpowiedzi w LangChain.

Jak budować szablony podpowiedzi w LangChain?

Aby zbudować szablony podpowiedzi w LangChain, wystarczy przejść przez następujący przewodnik składający się z kilku kroków:

Krok 1: Zainstaluj moduły i skonfiguruj środowisko

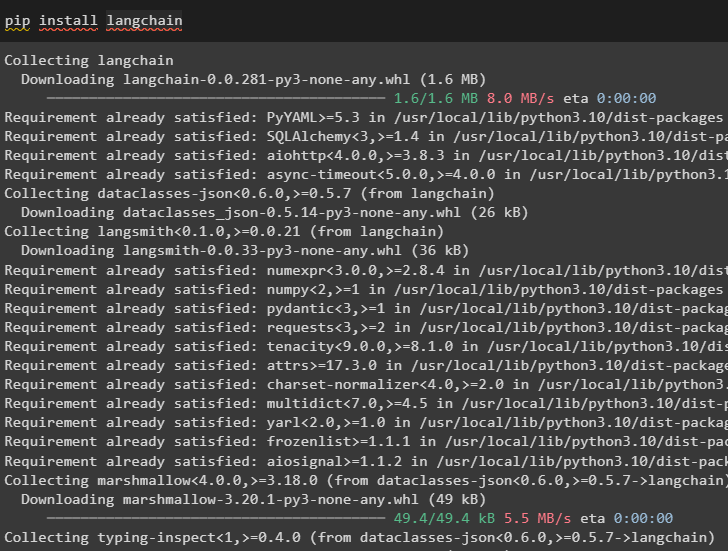

Rozpocznij proces budowania szablonów podpowiedzi w LangChain, instalując framework LangChain:

pip zainstaluj langchain

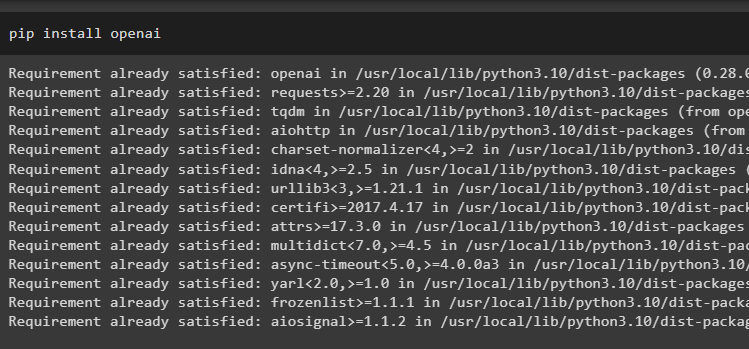

Teraz zainstaluj moduły OpenAI, aby uzyskać dostęp do ich bibliotek i skonfiguruj środowisko, korzystając z nich:

pip zainstaluj openai

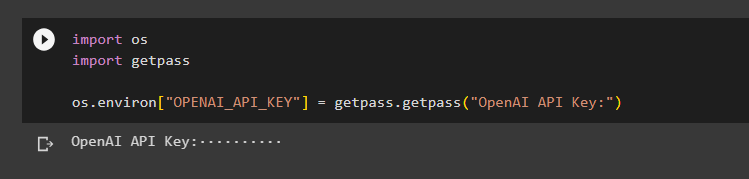

Skonfiguruj Środowisko OpenAI używając biblioteki os, aby uzyskać dostęp do systemu operacyjnego i podać klucz API OpenAI:

importuj naszaimportuj getpass

os.environ['OPENAI_API_KEY'] = getpass.getpass('Klucz API OpenAI:')

Krok 2: Korzystanie z szablonu podpowiedzi

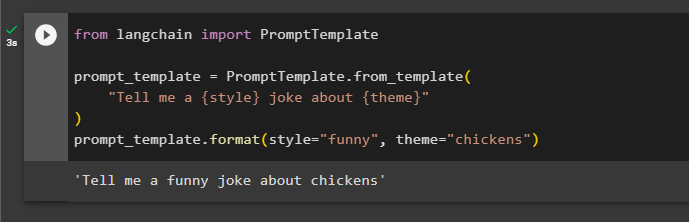

Po zainstalowaniu LangChain wystarczy zaimportować bibliotekę PromptTemplate i zbudować szablon zapytania dotyczącego żartu z dodatkowymi aspektami, takimi jak zmienne, takie jak przymiotnik, treść itp.:

z langchain import PromptTemplatePrompt_template = PromptTemplate.from_template(

„Opowiedz mi dowcip w stylu {style} na temat {theme}”

)

Prompt_template.format(style='zabawne', motyw='kurczaki')

Podpowiedź została ustawiona i podana modelowi z wartościami zmiennej wstawionej w poleceniu:

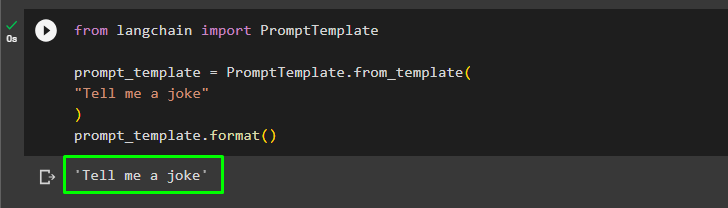

Użytkownik może dostosować szablon podpowiedzi za pomocą prostego zapytania z prośbą o żart:

z langchain import PromptTemplatePrompt_template = PromptTemplate.from_template(

'Opowiedz mi dowcip'

)

Prompt_template.format()

Powyższa metoda dotyczy pojedynczego zapytania i odpowiedzi, ale czasami użytkownik chce wejść w interakcję z modelem w formie czatu, a następna sekcja wyjaśnia jej format.

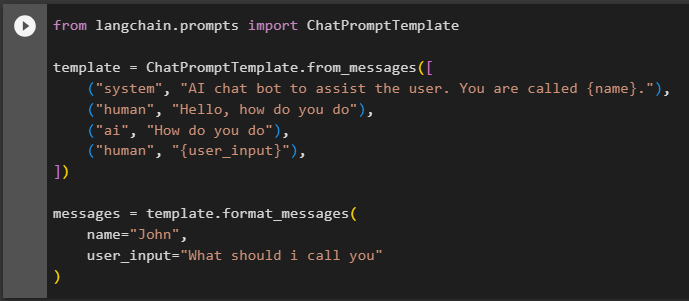

Krok 3: Korzystanie z szablonu podpowiedzi czatu

W tej sekcji wyjaśniono szablon modelu czatu, który opiera się na schemacie konwersacji, takim jak dwoje ludzi wchodzących w interakcję ze sobą:

z langchain.prompts importuj ChatPromptTemplateszablon = ChatPromptTemplate.from_messages([

(„system”, „bot chatowy AI pomagający użytkownikowi. Nazywasz się {imię}.”),

(„człowiek”, „Cześć, jak się masz”),

(„ai”, „Jak się masz”),

(„człowiek”, „{user_input}”),

])

wiadomości = szablon.format_wiadomości(

imię='Jan',

user_input='Jak mam do ciebie zadzwonić'

)

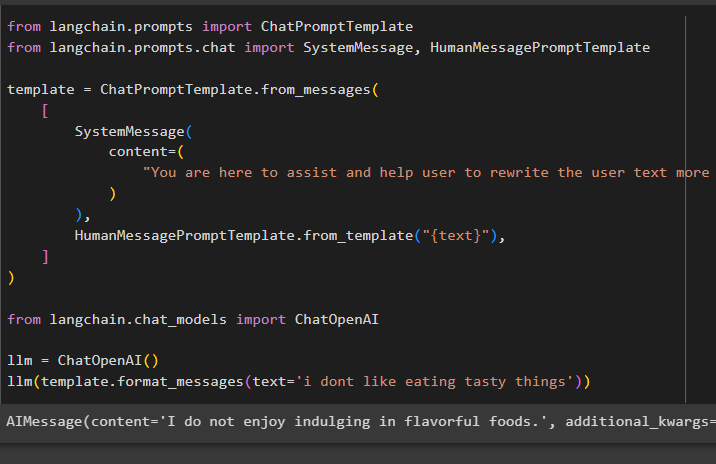

Po ustawieniu struktury szablonu po prostu napisz kilka wierszy w tekście, aby poinformować model, czego się od niego oczekuje, i użyj funkcji llm(), aby wyświetlić podpowiedź:

z langchain.prompts importuj ChatPromptTemplatez langchain.prompts.chat importuj SystemMessage, HumanMessagePromptTemplate

szablon = ChatPromptTemplate.from_messages(

[

Wiadomość systemowa(

treść=(

„Jesteś tutaj, aby pomóc użytkownikowi w skuteczniejszym przepisaniu tekstu użytkownika”

)

),

HumanMessagePromptTemplate.from_template('{text}'),

]

)

z langchain.chat_models importuj ChatOpenAI

llm = ChatOpenAI()

llm(template.format_messages(text='nie lubię jeść smacznych rzeczy'))

Metoda SystemMessage() zawiera treść odpowiedzi na zapytanie użyte w LLM:

To wszystko, jeśli chodzi o budowanie szablonów podpowiedzi w LangChain.

Wniosek

Aby zbudować szablon podpowiedzi w LangChain, wystarczy zainstalować moduły LangChain i OpenAI, aby skonfigurować środowisko przy użyciu klucza OpenAI API. Następnie utwórz szablon podpowiedzi dla pojedynczego monitu, na przykład pytania o żart lub pojedynczego pytania o cokolwiek. Inną metodą jest dostosowanie szablonu modelu czatu w oparciu o proces interakcji dwóch różnych ludzi. Ten post ilustruje proces budowania szablonu podpowiedzi w LangChain.