Czyszczenie danych za pomocą Pythona i Pand

Dane są dziś niczym elementy składowe procesu decyzyjnego. Ale wyobraź sobie, że masz grupę bloków o różnych kształtach i rozmiarach z tej kolekcji; ciężko jest zbudować coś sensownego. W tym miejscu z pomocą przychodzi czyszczenie danych.

W tym przewodniku omówiono sposoby czyszczenia danych przy użyciu frameworka Pythona, jakim jest Pandas, w celu lepszego podejmowania decyzji. Czyszczenie danych jest również istotne, biorąc pod uwagę, że pracujemy z listą rekordów sprzedaży dla sklepu. Możemy zauważyć brakujące liczby, dziwne daty i powtarzające się elementy na liście bez powodu. Jeśli dokonamy obliczeń lub zapisów na podstawie tych informacji, problemy te mogą zepsuć nasze obliczenia i przewidywania. Czyszczenie danych pomaga rozwiązać te problemy, zapewniając, że nasze dane są dokładne i gotowe do użycia.

Czyszczenie danych obejmuje obsługę brakujących danych i postępowanie w przypadku braku niektórych danych, usuwanie duplikatów, pozbywanie się skopiowanych elementów, poprawianie typów danych, upewnianie się, że wszystko ma właściwy format oraz radzenie sobie z wartościami odstającymi i obsługą liczb które nie pasują. Błędy te powodują, że dane wyglądają tak samo i standaryzują sposób ich wyświetlania.

Aby rozpocząć, upewnij się najpierw, że mamy zainstalowane Python i Pandy. Możemy to zrobić wpisując polecenia w terminalu naszego komputera lub w wierszu poleceń. Aby zaimplementować kody wymienione w tym przewodniku, możemy użyć Python Pycharm IDE zainstalowanego w naszym systemie lub internetowej platformy Pythona, jaką jest „Google Colab”, i zainstalować polecenia „pip”, aby zainstalować ważne biblioteki.

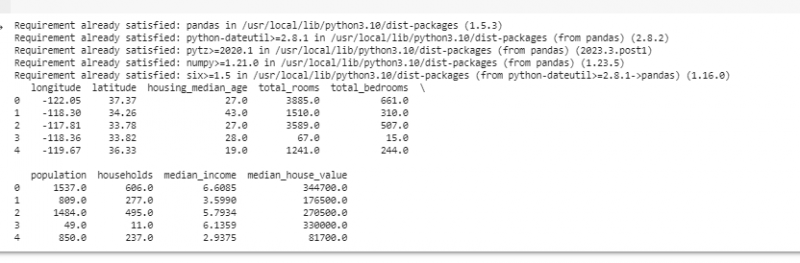

Teraz zaimportujmy Pandy i załadujmy nasze przykładowe dane. W tym przykładzie używamy Google Colab do uruchamiania kodów. Zatem najpierw importujemy Pandy, wprowadzając następujące polecenie:

! pip zainstaluj pandy

import pandy Jak pd

import tępy Jak np

Następnie ładujemy zbiór danych, który chcemy wyświetlić, za pomocą metody pd.read(), która jako parametr wejściowy przyjmuje ścieżkę pliku.

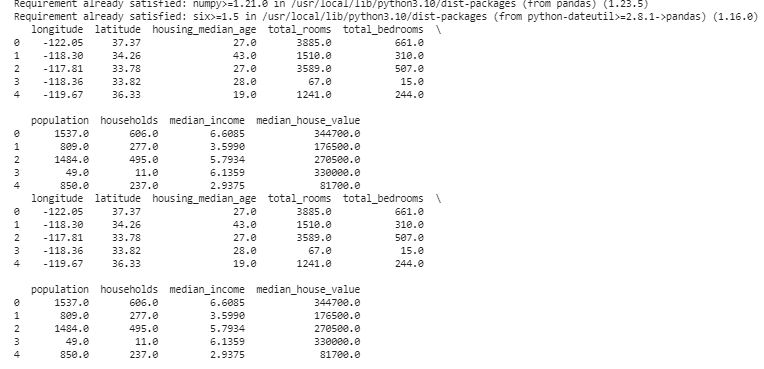

# Załaduj zestaw danychdane = pd. czytaj_csv ( „/content/sample_data/california_housing_test.csv” )

# Wyświetl kilka pierwszych wierszy

wydrukować ( dane. głowa ( ) )

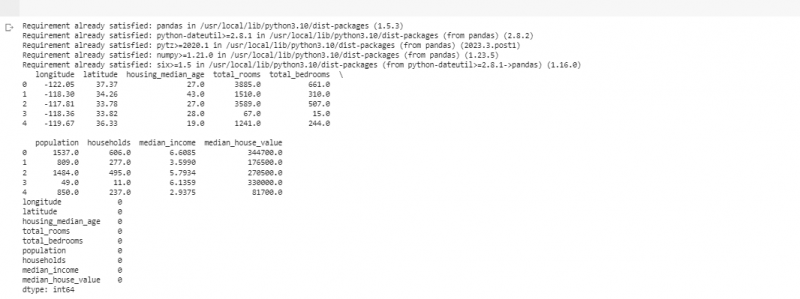

W kolejnym przykładzie wykorzystamy dane dotyczące sprzedaży w małym sklepie. Aby poradzić sobie z brakującymi danymi, czasami w naszych danych brakuje odpowiednich informacji. Te brakujące części nazywamy „NaN” (co oznacza „nie liczbę”). Aby znaleźć te brakujące wartości w skrypcie Pythona, najpierw ładujemy zestaw danych, tak jak to zrobiliśmy w poprzednim przykładzie. Następnie znajdujemy brakujące wartości w zbiorze danych za pomocą funkcji „missing_values = data.isnull().sum()”. Ta funkcja znajduje wszystkie brakujące wartości w zbiorze danych. Następnie wyświetlamy je za pomocą funkcji print().

! pip zainstaluj pandyimport pandy Jak pd

import tępy Jak np

# Załaduj zestaw danych

dane = pd. czytaj_csv ( „/content/sample_data/california_housing_test.csv” )

# Wyświetl kilka pierwszych wierszy

wydrukować ( dane. głowa ( ) )

# Sprawdź brakujące wartości

brakujące wartości = dane. jest null ( ) . suma ( )

# Wyświetl liczbę brakujących wartości według kolumny

wydrukować ( brakujące wartości )

Po znalezieniu brakujących danych w dowolnym wierszu uruchamiającym wspomniany wcześniej kod, możemy usunąć te wiersze, ponieważ nie zawierają one zbyt wiele przydatnych danych. Możemy nawet odgadnąć te brakujące wartości i wypełnić puste miejsca domysłami, szacując dane oparte na czasie na podstawie pobliskich punktów.

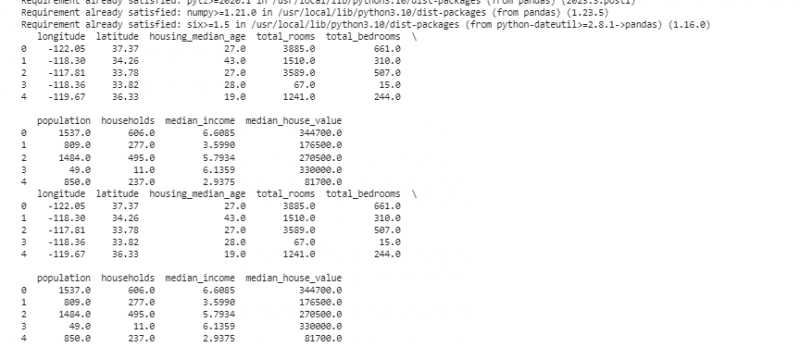

Teraz usuwamy duplikaty, które są kopiami tego samego, ponieważ mogą mylić naszą analizę. Aby znaleźć zduplikowane wartości w zbiorze danych, używamy funkcji „duplicate_rows = data[data.duplicated()]”. Aby usunąć te zduplikowane wartości, wywołujemy funkcję data.drop_duplicates(). Możemy je znaleźć i usunąć za pomocą następującego kodu:

! pip zainstaluj pandyimport pandy Jak pd

import tępy Jak np

# Załaduj zestaw danych

dane = pd. czytaj_csv ( „/content/sample_data/california_housing_test.csv” )

# Wyświetl kilka pierwszych wierszy

wydrukować ( dane. głowa ( ) )

# Sprawdź, czy nie ma zduplikowanych wierszy

duplikaty_wierszy = dane [ dane. zduplikowane ( ) ]

# Usuń duplikaty

dane = dane. drop_duplikaty ( )

# Wyświetl kilka pierwszych wierszy po usunięciu duplikatów

wydrukować ( dane. głowa ( ) )

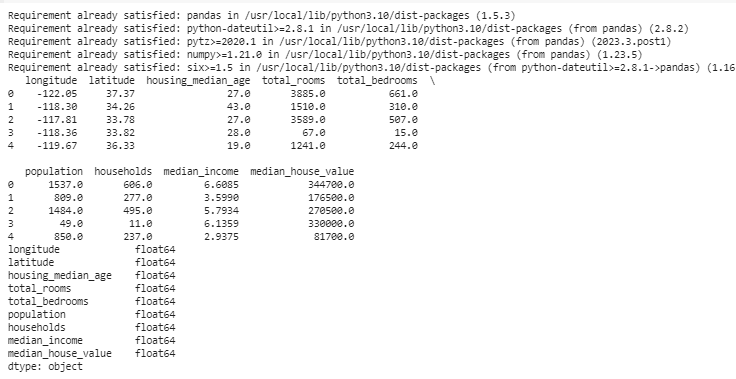

Typy danych decydują, jakie dane mogą być przechowywane, aby naprawić typy danych. Ważne jest, aby mieć odpowiedni typ dla każdego rodzaju danych. Na przykład daty powinny mieć typ danych datetime, a liczby powinny być typu int, float itp. Aby sprawdzić typy danych naszych danych, używamy funkcji „data.dtypes”. Funkcję tę można wykorzystać w następujący sposób:

! pip zainstaluj pandyimport pandy Jak pd

import tępy Jak np

# Załaduj zestaw danych

dane = pd. czytaj_csv ( „/content/sample_data/california_housing_test.csv” )

# Wyświetl kilka pierwszych wierszy

wydrukować ( dane. głowa ( ) )

# Sprawdź typy danych w każdej kolumnie

typy_danych = dane. typy

# Wyświetl typy danych

wydrukować ( typy_danych )

Jeśli znajdziemy jakieś problemy, możemy zmienić typ danych za pomocą Pand. Na przykład możemy nadać datom format daty. Atrybut „dtypes” ramki DataFrame dostarcza informacji o typach danych każdej kolumny. Jeśli stwierdzimy, że typy danych są niezgodne, możemy użyć funkcji astype() Pandy, aby przekonwertować kolumny na żądane typy.

Po typach danych czasami spotykamy wartości odstające, czyli wartości bardzo różniące się od pozostałych. Mogą zepsuć nasze obliczenia. Aby poradzić sobie z wartościami odstającymi, definiujemy funkcję korzystającą z funkcji z-score „np.abs(stats.zscore(data))”, która porównuje wartości istniejące w naszych danych z wartością progową. Każda wartość inna niż zakres tego progu jest uważana za wartość odstającą . Zobaczmy, jak znaleźć wartości odstające i sobie z nimi poradzić:

! pip zainstaluj pandyimport pandy Jak pd

import tępy Jak np

# Załaduj zestaw danych

dane = pd. czytaj_csv ( „/content/sample_data/california_housing_test.csv” )

# Wyświetl kilka pierwszych wierszy

wydrukować ( dane. głowa ( ) )

z pikantny import statystyki

def wykryć_odstające ( dane ) :

z_scores = np. abs ( statystyki. zscore ( dane ) )

powrót np. Gdzie ( z_scores > 3 )

# Wykrywaj i obsługuj wartości odstające w kolumnie „Sprzedaż”.

wartości odstające = wykryć_odstające ( dane [ 'długość geograficzna' ] )

dane [ 'długość geograficzna' ] . miejsce [ wartości odstające ] = dane [ 'długość geograficzna' ] . mediana ( )

# Wykrywaj i obsługuj wartości odstające w kolumnie „Sprzedane jednostki”.

wartości odstające = wykryć_odstające ( dane [ 'szerokość' ] )

dane [ 'szerokość' ] . miejsce [ wartości odstające ] = dane [ 'szerokość' ] . mediana ( )

# Wyświetl kilka pierwszych wierszy po obsłużeniu wartości odstających

wydrukować ( dane. głowa ( ) )

Używamy prostej metody, aby znaleźć i naprawić wartości odstające w poprzednim kodzie. Polega na zastąpieniu wartości skrajnych wartością środkową danych. Ten kod wykorzystuje metodę Z-score do wykrywania wartości odstających w kolumnach „długość” i „szerokość geograficzna” naszego zestawu danych. Wartości odstające są zastępowane medianą wartości odpowiednich kolumn.

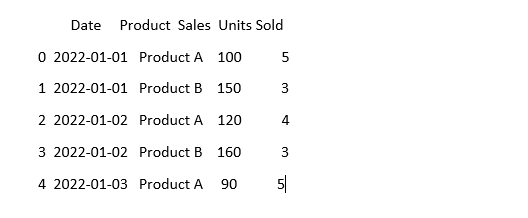

Aby dane wyglądały tak samo, czasami mogą wyglądać inaczej, nawet jeśli oznaczają to samo. Na przykład daty można zapisać w różnych formatach. Standaryzacja polega na zapewnieniu spójnego formatu i reprezentacji danych. Może to obejmować formatowanie dat, konwersję tekstu na małe litery lub normalizację wartości liczbowych. Ujednolicmy kolumnę „Data” w naszym zbiorze danych i zadbajmy o to, aby nasze dane wyglądały tak samo:

import pandy Jak pdimport tępy Jak np # Importuj numpy

# Załaduj dane

dane = pd. czytaj_csv ( „dane_sprzedaży.csv” )

# Spraw, aby kolumna „Data” wyglądała spójnie

dane [ 'Data' ] = pd. do_datagodzina ( dane [ 'Data' ] )

# Zobacz, jak to teraz wygląda

wydrukować ( dane. głowa ( ) )

W tym przykładzie standaryzujemy format daty w naszym zbiorze danych do formatu datetime Pythona za pomocą funkcji „pd.to_datetime(data[‘Date’])”. Konwertując kolumnę „Data” do tego samego formatu, ułatwiamy pracę z tymi danymi. Dane wyjściowe wyświetlają kilka pierwszych wierszy zbioru danych ze standardową kolumną „Data”.

Wniosek

Podczas naszej podróży przez czyszczenie danych przy użyciu Pythona i Pand dowiedzieliśmy się, jak ulepszyć nasze dane do analizy. Zaczęliśmy od zrozumienia, dlaczego czyszczenie danych jest tak ważne. Pomaga nam podejmować lepsze decyzje. Sprawdziliśmy, jak radzić sobie z brakującymi danymi, usuwać duplikaty, naprawiać typy danych, radzić sobie z wartościami odstającymi i sprawić, by nasze dane wyglądały tak samo. Dzięki tym umiejętnościom jesteśmy lepiej przygotowani do przekształcenia niechlujnych danych w coś, czemu możemy zaufać i wykorzystać do odkrycia ważnych informacji. Czyszczenie danych to proces ciągły, podobny do utrzymywania porządku w pokoju, dzięki któremu nasza analiza danych jest skuteczniejsza.