Składnia:

Ponieważ znamy ChatGPT, wiemy, że ta platforma jest własnością społeczności Open AI i zapewnia narzędzia, architektury, interfejsy API i kilka platform, które możemy wykorzystać we wdrażaniu naszych aplikacji i modeli przetwarzania języka naturalnego. Otwarta sztuczna inteligencja oferuje interfejsy API, dzięki którym możemy korzystać z dowolnych wstępnie wyszkolonych modeli sztucznej inteligencji i NLP z platformy Open AI i sprawić, by działały w naszych aplikacjach, na przykład w celu przewidywania danych w czasie rzeczywistym. Podobnie GPT4All umożliwia użytkownikom integrację wstępnie wyszkolonych modeli sztucznej inteligencji z różnymi aplikacjami.

Model GPT4All jest szkolony na ograniczonych danych w porównaniu z ChatGPT. Ma również pewne ograniczenia wydajności w porównaniu z ChatGPT, ale pozwala użytkownikowi korzystać z prywatnego GPT na lokalnym sprzęcie i nie wymaga żadnych połączeń sieciowych. Z pomocą tego artykułu dowiemy się, jak możemy używać modeli GPT4All w skrypcie Pythona, ponieważ GPT4All ma oficjalne powiązania z Pythonem, co oznacza, że możemy również używać i integrować modele GPT4All za pomocą skryptu Pythona.

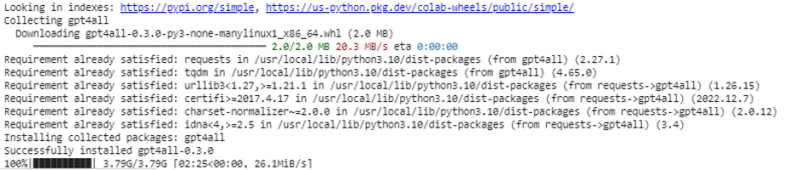

Wszystko wymaga polecenia online, aby zainstalować GPT4All dla Python IDE. Wtedy możemy zintegrować tyle modeli AI, ile naszych aplikacji. Polecenie instalacji tego GPT4All w Pythonie jest pokazane poniżej:

$ pip zainstaluj gpt4all

Przykład 1:

Aby zacząć od tego przykładu, musimy pobrać i zainstalować Pythona w naszych systemach. Zalecane wersje Pythona to „wersja 3.7” lub te, które pojawiły się po tej wersji. Innym sposobem pracy z Pythonem, aby uniknąć długiego procesu instalacji „konfiguracji Pythona” w naszych systemach, jest użycie „Google Colab”, które jest opartym na chmurze środowiskiem dla Pythona. Możemy uruchomić to środowisko w dowolnej przeglądarce internetowej i zbudować modele sztucznej inteligencji i uczenia maszynowego. Przykłady, które tutaj zaimplementujemy, są wykonywane w Google Colab.

W tym przykładzie opisano metodę instalacji GPT4All w języku Python oraz sposób korzystania z jego wstępnie wytrenowanych modeli. Zaczynamy od zainstalowania GPT4All. W tym celu wykonywane jest polecenie, o którym wspominaliśmy wcześniej. Po wykonaniu polecenia GPT4All wraz z pakietami i strukturami jest pobierany i instalowany.

Teraz ruszamy do przodu. Z GPT4All importujemy „GPT4All”. Spowoduje to dodanie do projektu wszystkich wstępnie wytrenowanych modeli z GPT4All. Teraz możemy wykorzystać dowolny pojedynczy model i sprawić, by wykonywał prognozy dla naszej aplikacji. Po zaimportowaniu pakietu GPT4All nadszedł czas, aby wywołać tę funkcję i użyć modelu GPT4All, który daje dane wyjściowe dla „ukończenia czatu”.

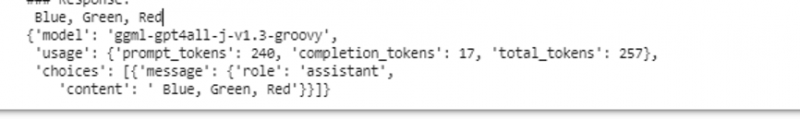

Innymi słowy, jeśli poprosimy o coś z tego modelu na wejściu, zwróci to na wyjściu. Model, którego tutaj używamy, to „ggml-gpt4all-j-v1.3-groovy”. Te modele są już przechowywane w pamięci podręcznej GPT4All. Możemy pobrać te modele z tego linku „ https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ” do ręcznego pobierania. Jeśli model jest już obecny w pamięci podręcznej GPT4All, po prostu wywołujemy nazwę modelu i określamy ją jako parametry wejściowe do funkcji „GPT4All()”. Jeśli pomyślnie pobraliśmy go ręcznie, przekazujemy ścieżkę do folderu, w którym znajduje się model. Ponieważ ten model służy do uzupełniania komunikatów, składnia tego modelu jest następująca:

$ Chat_completion (wiadomości)Komunikaty są listą słowników i każdy słownik powinien zawierać klucz „role” z wartością użytkownika, systemu lub asystenta oraz treść „klucza”, która ma wartość jako ciąg znaków. W tym przykładzie treść określamy jako „nazwij trzy kolory”, a klucz roli jako „użytkownik”.

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'role': 'użytkownik', 'content': 'Nazwij 3 kwiaty'}]

Po tej specyfikacji wywołujemy funkcję „chat_completion()” z modelem. Kod dla tego jest wyświetlany w następującym wyjściu:

$ !pip zainstaluj gpt4allz gpt4all zaimportuj GPT4All

model = GPT4All('ggml-gpt4all-j-v1.3-groovy')

wiadomości = [{'role': 'użytkownik', 'treść': 'Nazwij trzy kolory'}]

model.chat_completion(wiadomości)

Po wykonaniu tego przykładu model zwraca trzy kolory jako odpowiedź na dane wejściowe.

Przykład 2:

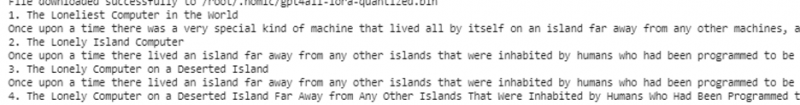

Omówimy inny przykład, w którym odkrywamy inną metodę użycia GPT4All w Pythonie. Można to zrobić za pomocą oficjalnych powiązań dla Pythona, które są dostarczane przez „Nomic”, która jest społecznością sztucznej inteligencji typu open source i obsługuje GPT4All. Za pomocą następującego polecenia integrujemy „nomic” z naszą konsolą Pythona:

$ pip nazwa instalacjiPo zainstalowaniu importujemy GPT4All z „nomic.gpt4all”. Po zaimportowaniu GPT4All inicjujemy GPT4All funkcją „open()”. Następnie wywołujemy funkcję „prompt()” i przekazujemy do tej funkcji monit. Następnie generowana jest odpowiedź na monit w oparciu o monit, który podaliśmy jako dane wejściowe do modelu podpowiedzi.

!pip zainstaluj nazwęz nomic.gpt4all zaimportuj GPT4All

# Zainicjuj model GPT4All

zainicjuj = GPT4All()

zainicjuj. otwórz()

# Generowanie odpowiedzi na podstawie monitu

model_response = inicjuj.prompt('napisz krótką historię o komputerze)

# wyświetlanie wygenerowanej odpowiedzi

drukuj(odpowiedź_modelu)

Dane wyjściowe wyświetlają szybką odpowiedź z modelu, który wygenerowaliśmy przy użyciu wstępnie wytrenowanego modelu GPT4All w języku Python. Jeśli chcemy dowiedzieć się więcej o modelach i o tym, jak możemy użyć tych modeli do generowania odpowiedzi, lub mówiąc prościej, jeśli chcemy zdobyć wiedzę na temat składni generowania odpowiedzi z tych modeli, możemy skorzystać z dalszej pomocy od GPT4Wszystkie szczegóły dokumentacji technicznej.

Wniosek

GPT4All wciąż dąży do uzyskania dokładności wydajności. Jest obsługiwany przez nomic platformę sztucznej inteligencji, której celem jest dostarczanie użytkownikom sztucznie inteligentnych chatbotów na procesorach klasy konsumenckiej, ponieważ GPT4All działa bez połączenia sieciowego i procesorów graficznych. Ten artykuł wyjaśnia nam, jak sprawnie używać PyGPT4All w środowisku Python i tworzyć interakcje między naszymi aplikacjami a wstępnie wyszkolonymi modelami AI GPT4All. W tym przewodniku omówiliśmy dwie różne metody instalacji GPT4All w Pythonie.