Ten post zilustruje proces tworzenia aplikacji LangChain przy użyciu szablonu podpowiedzi i parsera wyjściowego.

Jak budować aplikacje LangChain przy użyciu szablonu podpowiedzi i parsera wyjściowego?

Aby zbudować aplikację LangChain przy użyciu szablonu podpowiedzi i parsera wyjściowego, po prostu zapoznaj się z tym prostym przewodnikiem:

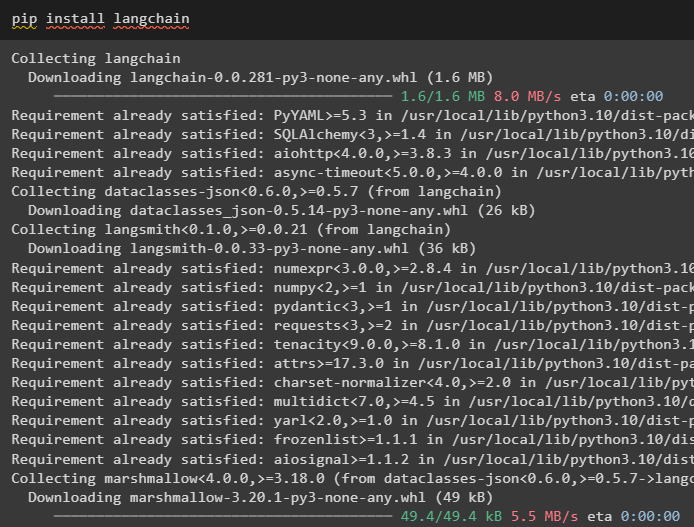

Krok 1: Zainstaluj LangChain

Najpierw rozpocznij proces tworzenia aplikacji LangChain, instalując framework LangChain za pomocą „ pypeć ' Komenda:

pip zainstaluj langchain

Krok 2: Korzystanie z szablonu podpowiedzi

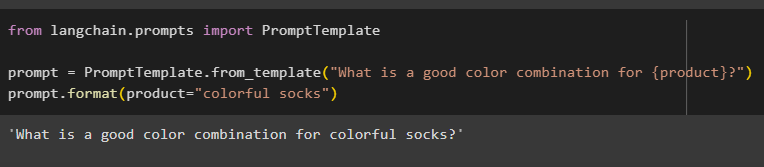

Po zainstalowaniu modułów LangChain zaimportuj plik „ Szablon podpowiedzi ” do zbudowania szablonu podpowiedzi poprzez podanie zapytania do modelu w celu zrozumienia pytania:

z langchain.prompts zaimportuj PromptTemplate

zachęta = PromptTemplate.from_template('Jaka jest dobra kombinacja kolorów dla {produktu}?')

Prompt.format(product='kolorowe skarpetki')

Dane wyjściowe automatycznie łączą zdanie z wartością „ produkt ' zmienny:

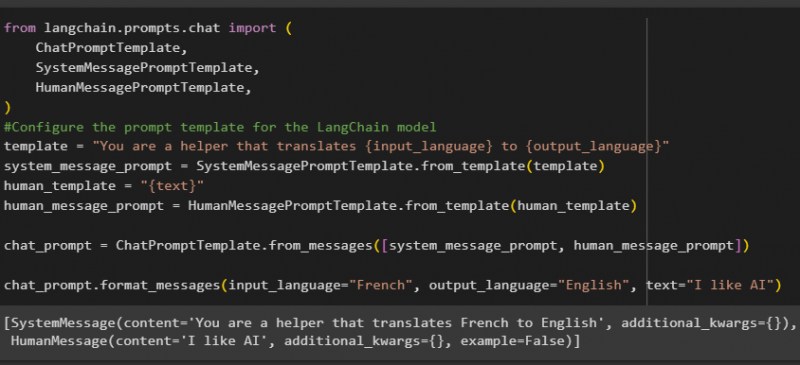

Następnie utwórz kolejny szablon podpowiedzi, importując biblioteki HumanMessagePromptTemplate, ChatPromptTemplate i SystemMessagePromptTemplate z LangChain:

z importu langchain.prompts.chat (Szablon ChatPrompt,

Szablon komunikatu systemowego,

Szablon HumanMessagePrompt,

)

#Skonfiguruj szablon podpowiedzi dla modelu LangChain

szablon = 'Jesteś pomocnikiem, który tłumaczy {input_language} na {output_language}'

system_message_prompt = SystemMessagePromptTemplate.from_template(szablon)

human_template = '{tekst}'

human_message_prompt = HumanMessagePromptTemplate.from_template(human_template)

chat_prompt = ChatPromptTemplate.from_messages([system_message_prompt, human_message_prompt])

chat_prompt.format_messages(input_language='francuski', wyjście_język='angielski', tekst='lubię sztuczną inteligencję')

Po zaimportowaniu wszystkich wymaganych bibliotek po prostu skonstruuj niestandardowy szablon dla zapytań, używając zmiennej szablonu:

Szablony podpowiedzi służą jedynie do ustawienia szablonu zapytania/pytania i nie odpowiadają na nie w postaci odpowiedzi. Jednakże funkcja OutputParser() może wyodrębnić odpowiedzi, jak wyjaśniono w poniższej sekcji na przykładzie:

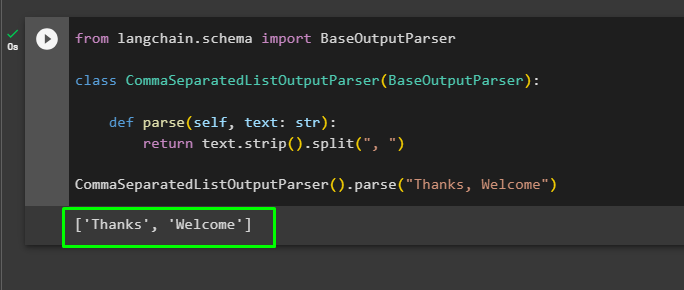

Krok 3: Korzystanie z parsera wyjściowego

Teraz zaimportuj bibliotekę BaseOutputParser z LangChain, aby oddzielić wartości tekstowe oddzielonymi przecinkami i zwrócić listę na wyjściu:

z langchain.schema zaimportuj BaseOutputParserklasa CommaSeparatedListOutputParser(BaseOutputParser):

def parse(self, tekst: str):

zwróć tekst.strip().split(', ')

CommaSeparatedListOutputParser().parse('Dzięki, witamy')

Wszystko sprowadza się do zbudowania aplikacji LangChain przy użyciu szablonu podpowiedzi i parsera wyjściowego.

Wniosek

Aby zbudować aplikację LangChain przy użyciu szablonu podpowiedzi i parsera wyjściowego, po prostu zainstaluj LangChain i zaimportuj z niego biblioteki. Biblioteka PromptTemplate służy do budowania struktury zapytania, dzięki czemu model może zrozumieć pytanie przed wyodrębnieniem informacji za pomocą funkcji Parser(). Funkcja OutputParser() służy do pobierania odpowiedzi na podstawie wcześniej dostosowanych zapytań. W tym przewodniku wyjaśniono proces tworzenia aplikacji LangChain przy użyciu szablonu podpowiedzi i parsera wyjściowego.