Składnia:

Istnieje wiele usług oferowanych przez Hugging Face, ale jedną z powszechnie używanych usług jest „API”. Interfejs API umożliwia interakcję wstępnie wyszkolonej sztucznej inteligencji i dużych modeli językowych z różnymi aplikacjami. Hugging Face zapewnia interfejsy API dla różnych modeli wymienionych poniżej:

- Modele generowania tekstu

- Modele translacji

- Modele analizy nastrojów

- Modele rozwoju wirtualnych agentów (inteligentne chatboty)

- Klasyfikacja i modele regresji

Odkryjmy teraz metodę uzyskiwania naszego spersonalizowanego interfejsu API wnioskowania z Hugging Face. Aby to zrobić, musimy najpierw zarejestrować się na oficjalnej stronie internetowej Hugging Face. Dołącz do tej społeczności Hugging Face, rejestrując się w tej witrynie za pomocą swoich danych uwierzytelniających.

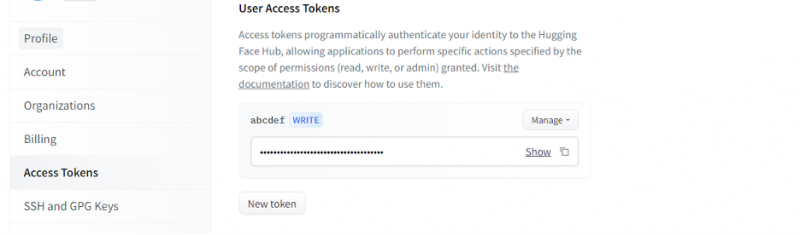

Gdy już otrzymamy konto na Hugging Face, musimy teraz poprosić o interfejs API wnioskowania. Aby zażądać API, przejdź do ustawień konta i wybierz „Token dostępu”. Otworzy się nowe okno. Wybierz opcję „New Token”, a następnie wygeneruj token, podając najpierw nazwę tokena i jego rolę jako „WRITE”. Generowany jest nowy token. Teraz musimy zapisać ten token. Do tego momentu mamy nasz żeton z Przytulającej Twarzy. W następnym przykładzie zobaczymy, jak możemy użyć tego tokena, aby uzyskać interfejs API wnioskowania.

Przykład 1: Jak prototypować za pomocą interfejsu API wnioskowania o przytulaniu twarzy

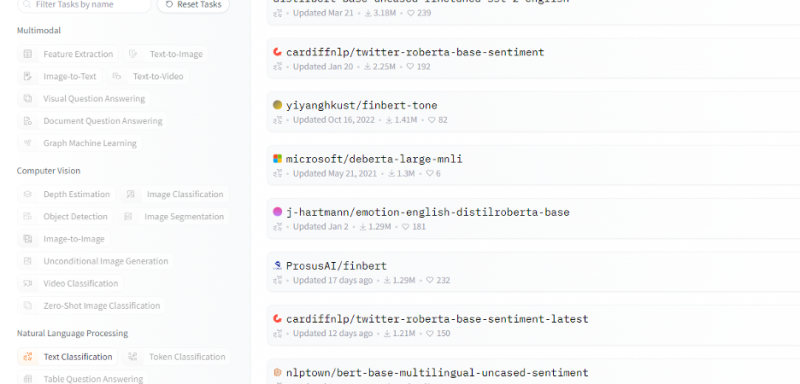

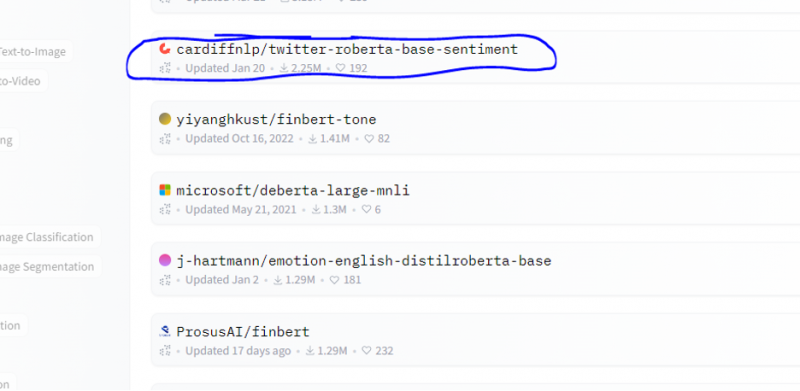

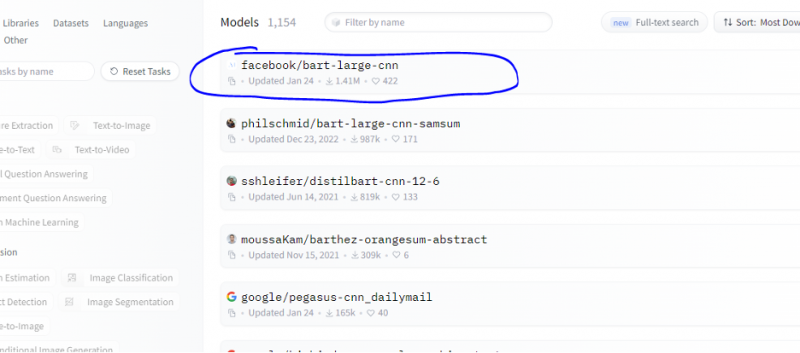

Do tej pory omówiliśmy metodę rozpoczęcia korzystania z Hugging Face i zainicjowaliśmy token z Hugging Face. Ten przykład pokazuje, jak możemy użyć tego nowo wygenerowanego tokena, aby uzyskać interfejs API wnioskowania dla określonego modelu (uczenie maszynowe) i dokonać za jego pomocą prognoz. Ze strony głównej Hugging Face wybierz dowolny model, z którym chcesz pracować i który jest odpowiedni dla twojego problemu. Załóżmy, że chcemy pracować z klasyfikacją tekstu lub modelem analizy tonacji, jak pokazano w poniższym fragmencie listy tych modeli:

Z tego modelu wybieramy model analizy sentymentu.

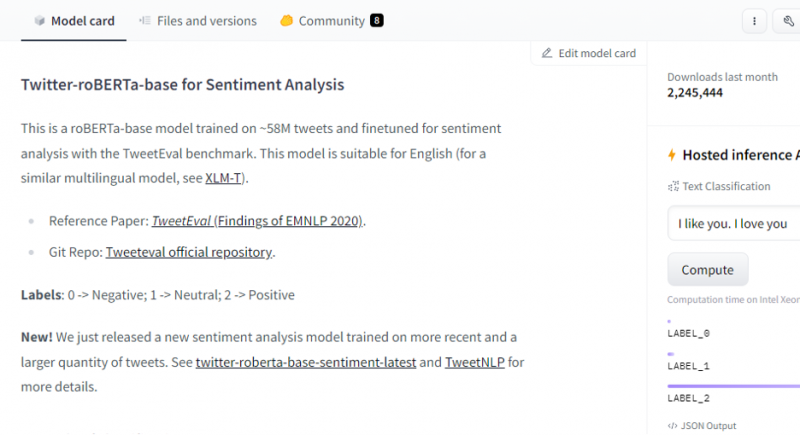

Po wybraniu modelu pojawi się jego karta modelu. Ta karta modelu zawiera informacje dotyczące szczegółów treningu modelu i jego cech charakterystycznych. Naszym modelem jest roBERTa-base, który jest szkolony na 58 milionach tweetów w celu analizy nastrojów. Ten model ma trzy główne etykiety klas i kategoryzuje każde wejście do odpowiednich etykiet klas.

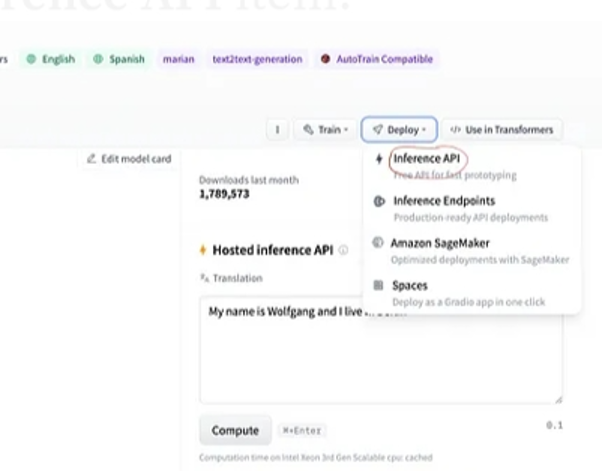

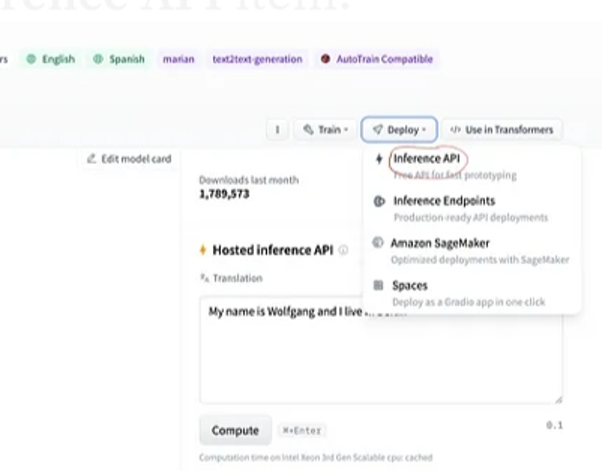

Po wybraniu modelu, jeśli wybierzemy przycisk wdrażania, który znajduje się w prawym górnym rogu okna, otworzy się menu rozwijane. Z tego menu musimy wybrać opcję „Inference API”.

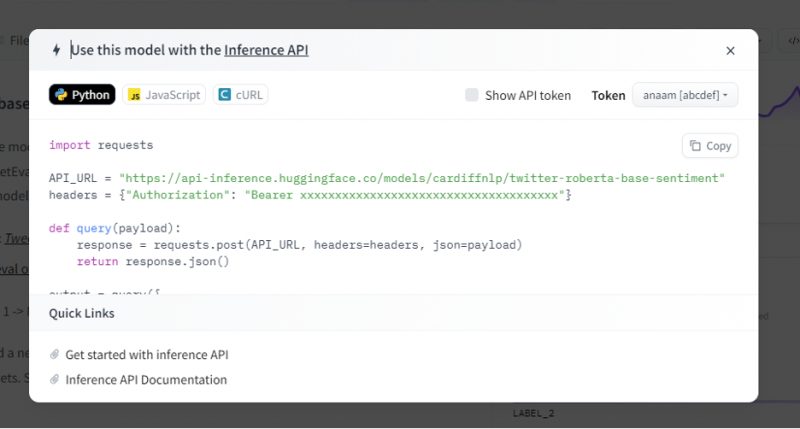

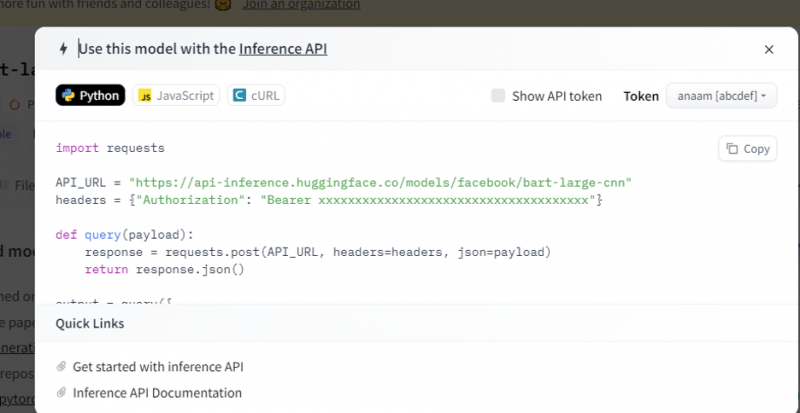

Interfejs API wnioskowania zapewnia następnie całe wyjaśnienie, jak używać tego konkretnego modelu z tym wnioskowaniem i pozwala nam szybko stworzyć prototyp dla modelu AI. Okno wnioskowania API wyświetla kod napisany w skrypcie Pythona.

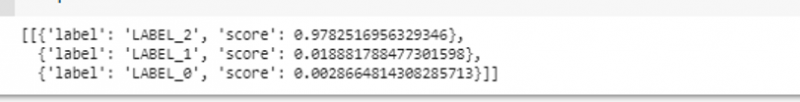

Kopiujemy ten kod i wykonujemy ten kod w dowolnym IDE Pythona. Używamy do tego Google Colab. Po wykonaniu tego kodu w powłoce Pythona zwraca dane wyjściowe zawierające wynik i przewidywaną etykietę. Ta etykieta i wynik są podane zgodnie z naszymi danymi wejściowymi, ponieważ wybraliśmy model „analizy nastrojów tekstowych”. Następnie dane wejściowe, które podajemy do modelu, to zdanie pozytywne, a model został wstępnie przeszkolony na trzech klasach etykiet: etykieta 0 oznacza negatywną, etykieta1 oznacza neutralną, a etykieta 2 jest ustawiona jako pozytywna. Ponieważ naszym wejściem jest zdanie pozytywne, prognoza wyniku z modelu jest większa niż pozostałe dwie etykiety, co oznacza, że model przewidział zdanie jako „pozytywne”.

import upraszanieAPI_URL = 'https://api-inference.huggingface.co/models/cardiffnlp/twitter-roberta-base-sentiment'

nagłówki = { 'Upoważnienie' : „Nosiciel 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” }

pok zapytanie ( ładunek ) :

odpowiedź = upraszanie. post ( API_URL , nagłówki = nagłówki , json = ładunek )

powrót odpowiedź. json ( )

wyjście = zapytanie ( {

„wejścia” : „Czuję się dobrze, kiedy jesteś ze mną” ,

} )

Wyjście:

Przykład 2: Model podsumowujący poprzez wnioskowanie

Wykonujemy te same kroki, które pokazano w poprzednim przykładzie, i tworzymy prototyp magistrali modelu podsumowania, korzystając z jej interfejsu API wnioskowania z Hugging Face. Model podsumowania jest wstępnie wytrenowanym modelem, który podsumowuje cały tekst, który mu przekazujemy jako dane wejściowe. Przejdź do konta Hugging Face, kliknij na modelkę z górnego paska menu, a następnie wybierz model, który ma znaczenie dla podsumowania, zaznacz go i uważnie przeczytaj jego kartę modelu.

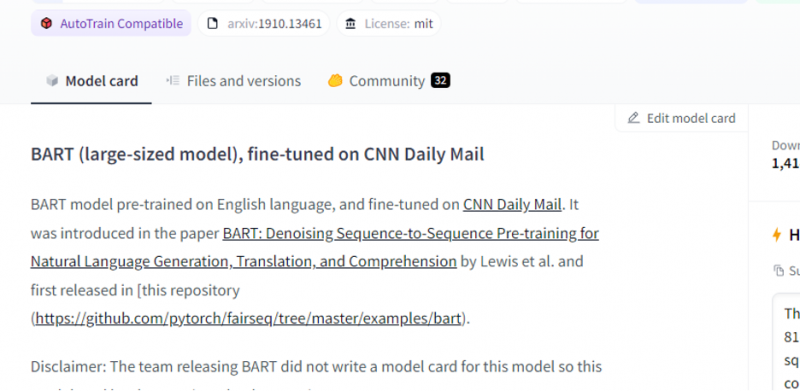

Model, który wybraliśmy, jest wstępnie wytrenowanym modelem BART i jest precyzyjnie dostrojony do zestawu danych poczty CNN. BART to model najbardziej zbliżony do modelu BERT, który posiada koder i dekoder. Ten model jest skuteczny, gdy jest dostrojony do zadań związanych ze zrozumieniem, podsumowywaniem, tłumaczeniem i generowaniem tekstu.

Następnie wybierz przycisk „wdrożenie” w prawym górnym rogu i wybierz interfejs API wnioskowania z rozwijanego menu. Interfejs API wnioskowania otwiera kolejne okno, które zawiera kod i wskazówki dotyczące używania tego modelu z tym wnioskowaniem.

Skopiuj ten kod i wykonaj go w powłoce Pythona.

Model zwraca dane wyjściowe, które są podsumowaniem danych wejściowych, które do niego wprowadziliśmy.

Wniosek

Pracowaliśmy nad interfejsem API Hugging Face Inference i nauczyliśmy się, jak możemy wykorzystać programowalny interfejs tej aplikacji do pracy z wytrenowanymi modelami językowymi. Dwa przykłady, które zrobiliśmy w artykule, były oparte głównie na modelach NLP. Hugging Face API może zdziałać cuda, jeśli chcemy opracować szybki prototyp, zapewniając szybką integrację modeli AI z naszymi aplikacjami. Krótko mówiąc, Hugging Face zawiera rozwiązania wszystkich problemów, od uczenia się przez wzmacnianie po widzenie komputerowe.